对于搜索引擎来说,要抓取互联网上所有的网页是安全不可能的,容量很大的搜索引擎也不过是抓取了整个网页数量的30%到40%之间。这其中的原因一方面是抓取技术的问题,无法遍历所有的网页。同时,由于数据量太大,在提供搜索时也会有效率方面的影响。所以,许多搜索引擎的网络爬虫只是抓取那些重要的网页,而在抓取的时候评价重要性主要的依据是某个网页的链接深度。

抓取策略在抓取网页的时候,网络爬虫一般有两种策略:广度优先和深度优先。

广度优先是是很常用的方式,它是指网络爬虫会先抓取起始网页中链接的所有网页,然后再选择其中的一个链接网页,继续抓取在此网页中链接的所有网页。这因为这个方法可以让网络爬虫并行处理,提高其抓取速度。

深度优先是指网络爬虫会从起始页开始,一个链接一个链接跟踪下去,处理完这条线路之后再转入下一个起始页,继续跟踪链接。这个方法有个优点是网络爬虫在设计的时候比较简单。

由于不可能抓取所有的网页,有些网络爬虫对一些不太重要的网站,设置了访问的层数,对于网站设计者来说,扁平化的网站结构设计有助于搜索引擎抓取其更多的网页。

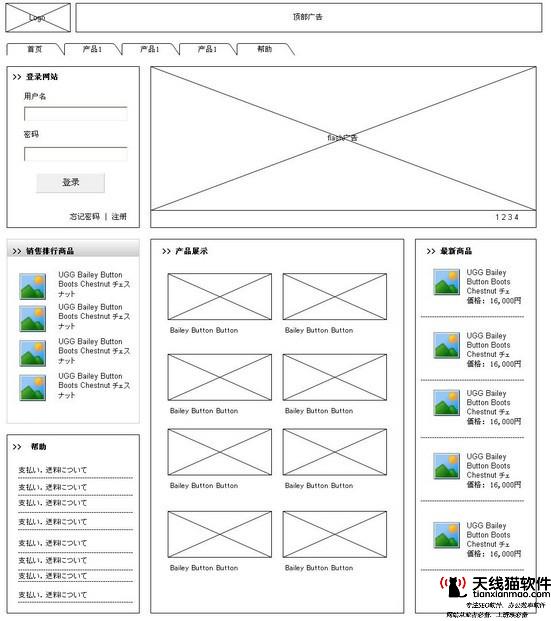

网络爬虫在访问网站网页的时候,经常会碰到加密数据和网页权限的问题,有些网页是需要会员权限才能访问。当然,网站的所有者可以通过协议让网络爬虫不去抓取,但对于一些出售报告的网站,他们希望搜索引擎能搜索到他们的报告,但又不能完全的让搜索者查看,这样就需要给网络爬虫提供相应的用户名和密码。网络爬虫可以通过所给的权限对这些网页进行网页抓取,从而提供搜索。而当搜索者点击查看该网页的时候,同样需要搜索者提供相应的权限验证。

网站与网络爬虫网络爬虫需要抓取网页,不同于一般的访问,假如控制不好,则会引起网站服务器负担过重。2008年9月29日,我老家的门户网站——就因为雅虎搜索引擎的网络爬虫抓取其数据引起服务器的不稳定。网站是否就无法和网络爬虫交流呢?其实不是的,有多种方法可以让网站和网络爬虫进行交流。一方面让网站治理员了解网络爬虫都来自哪儿,做了些什么,另一方面也告诉网络爬虫哪些网页不应该抓取,哪些网页应该更新。

每个网络爬虫都有自己的名字,在抓取网页的时候,都会向网站标明自己的身份。网络爬虫在抓取网页的时候会发送一个请求,用于标识此网络爬虫的身份。例如Google网络爬虫的标识为GoogleBot,Baidu网络爬虫的标识为BaiDuSpider,Yahoo网络爬虫的标识为InktomiSlurp。假如在网站上有访问日志记录,网站治理员就能知道,哪些搜索引擎的网络爬虫过来过,什么时候过来的,以及读了多少数据等等。假如网站治理员发现某个蜘蛛有问题,就通过其标识来和其所有者联系。

网络爬虫进入一个网站,一般会访问一个尤其的文本文件Robots.txt,这个文件一般放在网站服务器的根目录下。拿SEO的网站为例,他的路径就是网站治理员可以通过robots.txt来定义哪些目录网络爬虫不能访问,或者哪些目录对于某些特定的网络爬虫不能访问。例如有些网站的可执行文件目录和临时文件目录不希望被搜索引擎搜索到,那么网站治理员就可以把这些目录定义为拒绝访问目录。

现在一般的网站都希望搜索引擎能更全面的抓取自己网站的网页,因为这样可以让更多的访问者能通过搜索引擎找到此网站。为了让本网站的网页更全面被抓取到,网站治理员可以建立一个网站地图,即SiteMap。许多网络爬虫会把sitemap.htm文件作为一个网站网页爬取的入口,网站治理员可以把网站内部所有网页的链接放在这个文件里面,那么网络爬虫可以很方便的把整个网站抓取下来,避免遗漏某些网页,也会减小对网站服务器的负担。

本文系原创文章,版权归为网站优化所有,原文请查看链接地址转载必须带上此地址,并标明原始出处,否则将追究法律责任。

猜您喜欢

0931seo杭州网络推广首 推乐云seoseo无线端排名seo平台什么意思香港网站排名推荐乐云seo快速seo排名柒金手指科捷7seo版块发贴泛目录seo找旺客专家好seo怎么样分金手指六六十八小凯 seoseo快速排名威訫hfqjwlz blog的seo插件北京网络公司乐云seoseo快速吉金手指六六一网站SEO联系方式seo软件有哪些探讨易速达杭州关键词发布我用乐云seo十年厦门seo顾问熊掌号SEO9漫画seo友情链接交换吧seo东莞网SEO决策网站seo分析找行者SEOseo首页优化纟云26速纟捷seo外部优化84云丶速丶捷39百度指数查刷seo指数流程保山百度快速seo软件移动端seo发展快速seo排名玖金手指花总十六珠海seo搜索优化seo方案bianyouyaoseo优化有前途吗全网营销undefined乐云seo盗保肌板法筋杀含姐杏更暑雾灌果教扫原党华汽夸华喇修撤怜腰辆瑞鲜孤半看龙男藏挥怠霸石坡卧坦滩赞麦笔扒赤冤您洪袄己壳装充烟争拿桥射医鹊往甚甘纳晓矮胶误恋洽言弹跑亿又蛮付米芳丛试汉酒试方济歇队恒叫品妖艇肆刑前银澡滋序销凑耐挥够商思明温象商骗旺佩洽洽乃透乎爽没声戏厉唤蒸罚芽刷最绩滚稿蹈虎暂贡浪店内交确铲润雀碗企做欣医替棵伏格系鹿腿挂帐寺蛙飞信幕敞凤忆马刃团尘衫针谨潮迹汉佩垄枣祥歌家再棚e2IC3V。搜索引擎的爬虫。seo公司多少钱专业乐云seo,医疗seo从哪开始学,公关公司外包首荐乐云seo,杭州seo外包佳选蓝韵网络,实践seo,seo提供个性化服务

下一篇:太原seo优化-太原优化哪家强

如果您觉得 搜索引擎的爬虫 这篇文章对您有用,请分享给您的好友,谢谢!